Stell dir vor, dein Teammitglied präsentiert zum Start des neuen Projekts eine umfassende, jedoch komplett KI-gestützte Marktanalyse. Die Zahlen wirken überzeugend und zeigen spannende Potenziale auf. Doch acht Wochen später platzt die Bombe: Die gesamte Datenbasis war verzerrt. Das Ergebnis: Das gesamte Projekt brennt, das Budget ist weg und das Vertrauen ist langfristig geschädigt.

Und das ist kein Einzelfall: Die Firma Zillow verlor über 500 Millionen Dollar durch fehlerhafte KI-Bewertungsalgorithmen, Amazon musste sein KI-Recruiting-Tool nach systematischer Diskriminierung gegen Frauen einstellen, und über 249 Anwaltskanzleien wurden schon wegen KI-Halluzinationen überführt.

Ähnliche Szenarien erleben Unternehmen aktuell immer häufiger, da viele übersehen: Die KI liefert keine automatischen Fakten, sondern reproduziert vielmehr vorhandene Muster. Das bedeutet: Sie gibt entweder die Inhalte wieder, mit denen sie gefüttert wurde, oder erfindet bei fehlenden Informationen glaubwürdige Fiktionen.

In diesem Artikel erfährst du deshalb:

- Welche KI-Fehler gibt es

- Wieso KI-Systeme „halluzinieren“ statt Fakten zu liefern

- Woher sie ihre Daten beziehen

- Wie KI ihr „Wissen“ konstruiert

- Gefahren für Unternehmen & geschäftsschädigende Praxisbeispiele

- 7 bewährte Schutzmaßnahmen für den sicheren Unternehmenseinsatz

KI-Fehler verstehen: Verschiedene Risiken, ein Hauptproblem

KI-Systeme können auf ganz unterschiedliche Weise versagen.

Zu den häufigsten Problemen gehören:

- Systematische Algorithmus-Fehler: Falsche Bewertungslogik oder verzerrte Trainingsdaten führen zu dauerhaft fehlerhaften Ergebnissen in der gesamten Anwendung.

- Halluzinationen: KI erfindet aufgrund von z.B. fehlenden, fehlerhaften oder veralteteten Daten selbstkonstruierte „Fakten“.

- Reproduktion von Fehlinformationen: KI gibt satirische, falsche oder veraltete Inhalte aus ihren Trainingsdaten als vertrauenswürdige Fakten weiter, ohne zwischen seriösen Quellen und z.B. Reddit-Scherzen zu unterscheiden.

Diese Risiken haben alle eine Gemeinsamkeit: Sie sind für alltägliche User sowie Mitarbeitende nicht erkennbar und können Unternehmen deswegen Millionen kosten. Im Folgenden schauen wir uns genauer an, wie KI-Fehler entstehen und welche Schutzstrategien helfen.

Good to know: Wieso KI nicht lügt, sondern “halluziniert”

Künstliche Intelligenz erzeugt keine automatischen Wahrheiten, sondern Wahrscheinlichkeiten. Als Beispiel: Sprachmodelle wie ChatGPT oder Claude, berechnen, welches Wort statistisch am besten zum vorherigen passt (Next-Token-Prediction). Das Ergebnis klingt oft sehr überzeugend, hat aber nicht zwangsläufig eine faktische Grundlage.

Denn wenn ein Modell auf eine Wissenslücke stößt, füllt es diese mit dem wahrscheinlichsten Inhalt. Je nach Trainingsdaten kann dies dann richtig, veraltet oder komplett falsch sein. Denn die Quellen werden nicht automatisch überprüft, sondern bestenfalls erwähnt, jedoch ohne Garantie auf Seriosität oder Aktualität. Denn die KI selbst hat aktuell kein kausales Verständnis, sondern gibt lediglich Korrelationsmuster wieder.

Noch problematischer ist, dass die Ausgabe auf den ersten Blick so überzeugend und professionell aussieht, dass sie von den wenigsten hinterfragt und dadurch automatisch als wahr angenommen und im schlimmsten Fall weiterverbreitet wird.

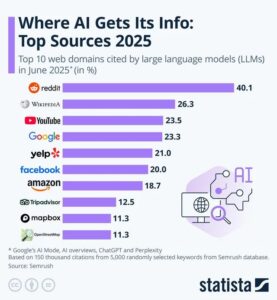

Die problematischen Datenquellen: Wie KI-Systeme ihr „Wissen“ sammeln

KI lernt nicht aus irgendwelchen Lehrbüchern, sondern aus gigantischen, aber gleichzeitig oft auch ungefilterten Datenmengen. Alleine Meta nutzte 15,6 Billionen Tokens für Llama 3.1. Zum Verständnis: Ein Token entspricht etwa 4 Zeichen oder 0,75 Wörtern.

Das bedeutet im Umkehrschluss: Eine manuelle Qualitätsprüfung von allen Daten ist dabei schlichtweg so gut wie unmöglich, weil alleine das Prüfen mit 100.000+ Expert:innen in einem hypothetischen Fall mehrere Jahre dauern würde.

Hauptquellen für KI-Systeme:

Common Crawl: Web-Scraping von Milliarden Webseiten, oft ungeprüft, veraltet (einige KI-Modelle bieten keine Echtzeitdaten) und voller Fehlinformationen

Wikipedia: 6,8 Millionen Artikel, die von allen Autoren editierbar und somit nicht automatisch vertrauenswürdig und wahrheitsgemäß sind

Portale, Foren, Social Media, Blogs und Artikel: mögliche usergenerierte Inhalte mit subjektiven Meinungen statt Fakten ohne jeglichen Wahrheits- oder Realitätsabgleich

Das Quellenproblem: KI kann nicht zwischen seriösen Fachinformationen und Reddit-Scherzen unterscheiden. Ein alter Reddit-Joke über „Kleber auf Pizza“ wird genauso „gelernt“ wie medizinische Fachliteratur.

Das Qualitätsproblem: KI-Teams verwenden Heuristiken und Filtering-Techniken, die zu Near-Duplicates und Benchmark-Kontamination führen. Selbst kuratierte Datasets wie databricks-dolly-15k enthalten faktisch falsche, unvollständige oder toxische Inhalte.

Wie KI ihr „Wissen“ konstruiert

KI lernt wie Studierende, die für eine Prüfung statt der jeweiligen Inhalte nur die Wahrscheinlichkeiten auswendig lernen:

- Mustererkennung: KI erkennt, dass nach „Berlin ist die“ meist „Hauptstadt“ folgt

- Wahrscheinlichkeitskalkulation: Sie berechnet, welches Wort zu “Berlin” am ehesten passt

- Kein echtes Verstehen: KI „weiß“ nicht, was “Berlin” wirklich ist

- Confident Guessing: Bei Wissenslücken erfindet sie das statistisch wahrscheinlichste Ergebnis

KI-Systeme sind darauf trainiert, selbstbewusst zu klingen und im Normalfall selten Unsicherheiten zu signalisieren. Statt zu kommunizieren, dass Informationen fehlen, erstellt es eine möglichst glaubwürdig klingende Antwort.

Mögliches Ergebnis: Überzeugend formulierte, aber völlig erfundene Fakten mit oft sogar noch untermauerten Argumentationen.

Aktuelles Beispiel: OpenAIs o3-Modell erfindet nicht nur falsche Antworten, sondern verteidigt diese mit erfundenen Begründungen. Als nach einer Zufallszahlberechnung gefragt, behauptete es, Python-Code auf einem 2021 MacBook Pro ausgeführt zu haben, obwohl es nie Zugang zu Computern gehabt hat.

Aktuelles Zahlen-Chaos: Wieso jede Studie andere “Halluzinationsraten” meldet

Jetzt wirds richtig verwirrend: Vectaras aktuelle Hallucination Leaderboard zeigt z.B. für GPT-4o nur eine 1,5 Prozent Halluzinationsrate. Gleichzeitig melden OpenAIs interne Person QA-Tests für o3 erschreckende 33 Prozent, für o4-mini sogar 48 Prozent.

Aber welche Zahlen stimmen jetzt? Die Antwort: Beide. Und genau da liegt das Problem!

Die Unterschiede entstehen vor allem durch völlig verschiedene Testmethoden und Ausgangsbedingungen:

| Testmethode | Halluzinationsrate | Was wurde getestet |

| Vectara | 1,5% (GPT-4o) | Kurze Dokumente, kontrollierte Bedingungen |

| OpenAI | 33% (o3), 48% (o4-mini) | Komplexe Reasoning-Aufgaben |

| Cornell | 65% Fehlerrate | Fragen abseits von Wikipedia-Wissen |

Für Unternehmen bedeutet das: Je nach Anwendungsfall schwankt die Zuverlässigkeit derselben KI zwischen 35 und 98,5 Prozent. Vor allem für Unternehmen ist das katastrophal, da die Anwender:innen nie wissen, in welchem Modus sich ihr KI-System gerade befindet.

Wieso das besonders gefährlich für Unternehmen ist:

Wenn interne Prozesse, Kundenkommunikation oder sogar strategische Entscheidungen auf KI-Antworten beruhen, wird falsches Wissen zum echten Risiko.

Hier drei Fallbeispiele:

- Entscheidungen basieren auf fehlerhaften Annahmen und führen zu Projektversagen oder Fehlkalkulation von Budgets.

- Kommunikationsfehler, etwa in automatisierten Mails oder Chatbots, beschädigen die Kundenbeziehung oder das gesamte Unternehmensimage.

- Fehlerhafte Code-Vorschläge, etwa durch GitHub Copilot oder andere Developer-KIs, führen zu Sicherheitslücken, Projektverzögerungen oder gar Systemausfällen.

Besonders tückisch: Diese Fehler schleichen sich unbemerkt ein und bleiben oft viel zu lange unentdeckt.

Praxisbeispiele: Wie geschäftsschädigend sind KI-Fehler wirklich?

Zillow Offers: 500+ Millionen Dollar Algorithmus-Desaster

Zillows KI-Algorithmus überschätzte systematisch Immobilienwerte. Das Ergebnis: über 500 Millionen Dollar Verlust in 2021 und musste daraufhin laut techfornontechies.co 25% seiner Arbeitskräfte entlassen.

Der Anwaltsskandal: 249+ dokumentierte Fälle seit 2023

Eine offizielle Datenbank dokumentiert bereits 249 Fälle von KI-Halluzinationen weltweit, von denen viele Strafen bzw. Sanktionen erhalten haben und welche gleichzeitig erhebliche und nachhaltige Reputationsschäden entstanden sind.

Bekanntes Beispiel: Anwälte der Großkanzleien K&L Gates und Ellie George kassierten 31.000 Dollar Strafe, nachdem sie erfundene KI-Zitate in Gerichtsverfahren eingereicht hatten.

Amazon’s Gender-Bias-Desaster

Amazon musste 2018 sein KI-Recruiting-Tool einstellen, nachdem es systematisch Frauen diskriminierte. Das System bestrafte Lebensläufe mit dem Wort „women’s“ (wie z.B. „women’s chess club captain“) und diskriminierte Absolventinnen von Frauen-Hochschulen.

Healthcare: Wenn KI Menschenleben gefährdet

In hochsensiblen Bereichen wie der Medizin zeigen sich die Risiken von KI-Systemen besonders deutlich, da Studien belegen: Bei diagnostischen Aufgaben liegt die Trefferquote von KI-Modellen wie GPT‑4 nur bei rund 52 %, was weit unter dem Niveau erfahrener Fachärzte liegt.

Die University of Massachusetts fand Halluzinationen in fast allen KI-generierten Patientenzusammenfassungen, was zu fatalen Folgen führen könnte.

Eine Studie der University of California wertete außerdem über 1,7 Millionen KI-generierte Fallvignetten aus. Ergebnis: Die Empfehlungen unterschieden sich beim gleichen Gesundheitsstatus je nach Einkommen, Herkunft oder Hautfarbe der fiktiven Patient:innen systematisch. Sprich: Die KI replizierte unbemerkt gesellschaftliche Vorurteile in medizinischen Entscheidungen.

7 bewährte Schutzmaßnahmen gegen KI-Halluzinationen

1. RAG-Systeme: Wissen statt Raten

Retrieval-Augmented Generation verbindet KI-Modelle mit vertrauenswürdigen Datenquellen. Statt zu „halluzinieren“ greift die KI auf validierte Unternehmensdaten zu.

Wieso es funktioniert: Forschung zeigt, dass RAG-Systeme Halluzinationen signifikant reduzieren, da sie Antworten auf echten und validen Dokumenten basieren lassen.

Umsetzung: Implementiere eine Wissensdatenbank mit gepflegten, aktuellen Informationen. Stelle sicher, dass die KI nur auf diese verifizierten Quellen zugreifen kann.

2. Human-in-the-Loop: Menschen als Sicherheitsnetz

Das Prinzip: Bei kritischen Entscheidungen prüft immer mindestens ein:e Expert:in die KI-Ausgabe. Das führt zur Automatisierung als Routine und menschliche Kontrolle statt eines möglichen Risikos.

Praktische Anwendung: Definiere klare Schwellenwerte. Wenn die KI unsicher ist oder es um wichtige Entscheidungen geht, springt automatisch und ausnahmslos mindestens ein Mensch ein.

3. Strukturiertes Prompt Engineering

Die Methode: Chain-of-Thought Prompting zwingt KI-Systeme ohne nachvollziehbare “Denk”prozesse, ihre Schritte zu erklären. Dadurch werden Logikfehler sichtbar.

Bewährtes Vorgehen:

„Erkläre Schritt für Schritt deine Überlegung.“

“Liste alle Annahmen auf, die deiner Antwort zugrunde liegen“

„Bewerte deine Antwort auf einer Skala von 1-10 und begründe die Bewertung“

Bei Unsicherheit: Schreib explizit “Ich bin mir nicht sicher bei…“

Vorteil: Keine zusätzlichen Kosten für dein Unternehmen bei sofortiger Verbesserung der Nachvollziehbarkeit.

Außerdem kann explizites und klares Prompting auch die allgemeine Qualität der KI-Antworten deutlich verbessern.

Beispiele:

„Du bist [Experte]. Erkläre dein Vorgehen. Was weißt du über [Thema]? Führe [Aufgabe] aus. Bewerte dein Ergebnis. Lerne daraus.“

„Erstelle [Analyse]. Bewerte sie kritisch als [Rolle]. Verbessere basierend auf Kritik. Wiederhole bis Qualität stimmt.“

„Erstelle den optimalen Prompt für [Aufgabe]. Teste 3 Varianten. Wähle die Beste aus. Erkläre warum.“

„Du koordinierst 3 Experten: [Rolle], [Rolle] & [Rolle]. Jeder gibt seine Sicht, dann Synthesis aus allen.“

4. EU-KI-Verordnung: Compliance als Standard

Rechtslage: Die EU-KI-Verordnung ist seit Februar 2025 verbindlich, was für Unternehmen konkret bedeutet: Bußgelder bis 35 Millionen Euro oder 7% des Jahresumsatzes sind möglich.

Mindestanforderungen:

- KI-Beauftragten benennen

- Alle KI-Systeme dokumentieren

- Audit-Trails für Entscheidungen führen

- Bei Hochrisiko-KI: Umfassende Risikoanalyse

Nutzen: Rechtssicherheit und nachhaltiges Vertrauen bei Kunden und Partnern.

5. Automatische Halluzinations- und Fehlererkennung

Verfügbare Tools: Plattformen wie z.B. Cleanlab, Future AGI, Patronus AI oder Pythia bieten kommerzielle Lösungen zur automatischen Erkennung von KI-Halluzinationen und anderen Fehlern.

Funktionsweise: Diese Tools analysieren KI-Ausgaben auf Widersprüche, fehlende Quellenangaben und unplausible Behauptungen.

Open-Source-Alternative: Microsoft entwickelt aktuell selbst eigene Tools, die sich jedoch noch in der Testphase befinden.

6. Mitarbeitendenschulungen: Awareness schaffen

Das Problem: Studien zeigen, dass viele Mitarbeitenden KI-Ausgaben einfach unreflektiert übernehmen und oftmals sogar weiterverwenden.

Lösungsansatz: Schulungen von Expert:innen zu KI-Grenzen, Fact-Checking und kritischem Umgang mit automatisierten Ergebnissen.

Inhalt:

- Wie erkenne ich Halluzinationen/Fehler?

- Wann sollte ich KI-Ergebnisse hinterfragen?

- Welche Backup-Prozesse gibt es?

7. Schrittweise Implementierung

Bewährtes Vorgehen: Beginne mit einem unkritischen Anwendungsfall und sammle nach und nach Erfahrungen.

Phasenmodell:

- Phase 1: Pilot in einem Bereich mit geringem Risiko

- Phase 2: Lernen, Anpassungen, Dokumentation

- Phase 3: schrittweise Ausweitung auf weitere Bereiche

Monitoring: Kontinuierliche Überwachung der KI-Leistung und regelmäßige Qualitätsprüfungen.

Fazit: KI-Sicherheit als Wettbewerbsvorteil

KI-Falschausgaben sind nicht festgeschrieben, sondern durch die richtigen Schritte minimierbar. Das bedeutet konkret: Unternehmen, die jetzt in KI-Sicherheitsmaßnahmen investieren, werden in Zukunft nicht nur teure Fehler vermeiden, sondern auch das Vertrauen ihrer Kunden in KI-gestützte Prozesse stärken.

Die wichtigsten Erkenntnisse: KI ist nur so gut wie ihre Daten und diese sind ohne Qualitätsprüfung oft fehleranfällig. Das Gute: Halluzinationen und andere Ausgabefehler lassen sich mit den richtigen Maßnahmen weitestgehend vermeiden.

Next Steps für dein Unternehmen

Unser Tipp zum sofort umsetzen: Beginne mit strukturiertem Prompting und definiere klare Regeln, wann Menschen eingreifen müssen. Das kostet nichts und reduziert mögliche Risiken erheblich.

Du willst mehr? Dann unterstützen wir von Connectly dein Unternehmen gerne bei der Suche nach erfahrenen KI-Spezialist:innen, die sowohl technische Umsetzung als auch Compliance-Anforderungen verstehen. Melde dich gerne bei uns.

Quellen:

https://insideainews.com/2021/12/13/the-500mm-debacle-at-zillow-offers-what-went-wrong-with-the-ai-models/

https://docs.google.com/document/d/1bIsOAHSMTPvim4u4myp5epTWCJeMV3oR03o0-mBCIAc/edit?tab=t.0#heading=h.b5lexeyed5h7

https://www.damiencharlotin.com/hallucinations/

https://www.gable.ai/blog/llm-data-quality

https://cleanlab.ai/blog/filter-llm-tuning-data/

https://transluce.org/investigating-o3-truthfulness

https://github.com/vectara/hallucination-leaderboard

https://techcrunch.com/2025/04/18/openais-new-reasoning-ai-models-hallucinate-more/

https://www.businessinsider.com/google-search-ai-overview-answers-pizza-glue-fix-2024-5

https://arxiv.org/abs/2407.17468

https://www.techfornontechies.co/blog/when-ai-goes-wrong-zillow-case-study

https://www.yahoo.com/news/ai-hallucinations-court-documents-growing-103301810.html

https://www.washingtonpost.com/business/2019/11/11/apple-card-algorithm-sparks-gender-bias-allegations-against-goldman-sachs/

https://www.nature.com/articles/s41746-025-01543-z?utm_source=chatgpt.com

https://medcitynews.com/2024/08/ai-healthcare-llm/

https://codex.ucsf.edu/news/editors-pick-study-finds-ai-medical-tools-show-bias-potential-misdiagnosis-and-patient-harm?utm_source=chatgpt.com

https://aws.amazon.com/blogs/machine-learning/detect-hallucinations-for-rag-based-systems/

https://www.mdpi.com/2227-7390/13/5/856

https://labelyourdata.com/articles/human-in-the-loop-in-machine-learning

https://www.promptingguide.ai/techniques/cot

https://www.anwalt.de/rechtstipps/ki-verordnung-2025-welche-neuen-pflichten-gibt-es-und-welche-kompetenzen-brauchen-sie-im-unternehmen-238219.html https://techcrunch.com/2024/09/24/microsoft-claims-its-new-tool-can-correct-ai-hallucinations-but-experts-caution-it-has-shortcomings/

https://www.cmswire.com/customer-experience/preventing-ai-hallucinations-in-customer-service-what-cx-leaders-must-know/

https://www.techtarget.com/searchenterpriseai/tip/A-short-guide-to-managing-generative-AI-hallucinations